In Italia è stato sviluppato uno strumento che riconosce le intenzioni del bambino mediante la decodifica dei segnali elettrici prodotti dal cervello. Il tracciato viene elaborato da un computer e da algoritmi di intelligenza artificiale che ‘traducono’ questi segnali e li interpretano, dando gli ordini in questione a Pepper, un robot umanoide alto 1,21 cm. Articolo di Salvo Ingargiola apparso sul numero di Fortune Italia di febbraio 2020.

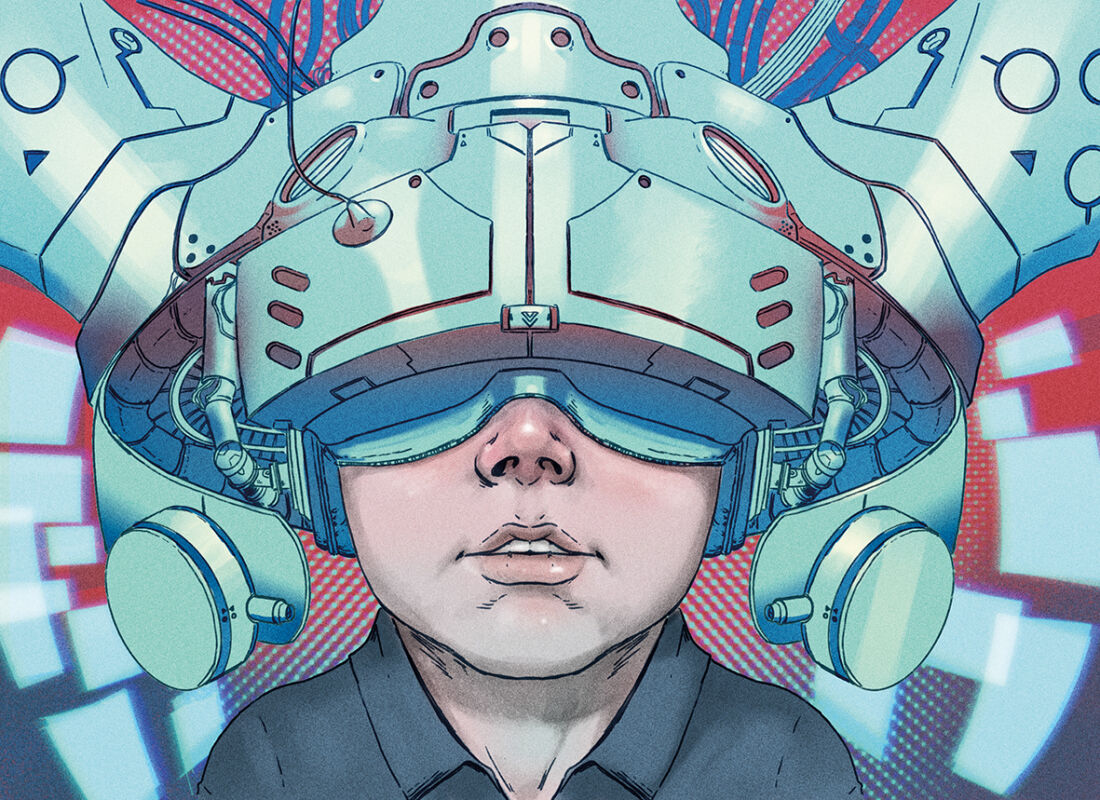

Bambini alle prese con robot e videogame. Stavolta, non per gioco ma perché parte di una ricerca condotta dall’Università di Padova in collaborazione con l’ateneo di Ferrara. Protagonisti i piccoli pazienti, di età compresa tra i 6 e i 14 anni su cui si concentra uno studio che, per la prima volta, ha analizzato in maniera sistematica cosa succede quando un bambino ‘pilota’ un computer o un robot, con il cervello. Si tratta di un esperimento di neurorobotica, una disciplina che studia come “la robotica si interfaccia con il sistema nervoso umano, ovvero con i segnali cerebrali che si generano durante il funzionamento del cervello”, come ci spiega Emanuele Menegatti, responsabile dello Ias-Lab (Intelligent autonomous systems laboratory). Non a caso, infatti, i bambini nel corso dello studio indossano un caschetto dotato di elettrodi. L’obiettivo è cogliere i segnali elettrici generati. Così facendo, si può ordinare a un robot o a un avatar in un videogame di ‘girare a destra’ o ‘a sinistra’ o, ancora ‘andare dritto’. Piccoli comandi, sottolinea Menegatti.

“D’altronde – spiega – non sappiamo come funziona il cervello. Quindi se io penso ‘rosso’, al momento, non sappiamo esattamente cosa succede all’interno della mente. Ciò che, di certo, sappiamo è la ‘zona’ che si attiva”. La ricerca – condotta dal Dipartimento di ingegneria dell’informazione del Bo di Padova – consiste dunque nel riconoscimento delle intenzioni del bambino mediante la decodifica dei segnali elettrici prodotti dal cervello. Il tracciato, anziché essere disegnato su carta, come in un normale elettroencefalogramma, viene elaborato da un computer e da algoritmi di intelligenza artificiale che ‘traducono’ questi segnali e li interpretano, dando gli ordini in questione a Pepper, un robot umanoide alto 1,21 cm.“Abbiamo così scoperto che in questi compiti il cervello dei bambini, pur essendo ancora in formazione, funziona allo stesso modo di quello degli adulti”, afferma Menegatti che, a Padova, guida uno staff (un ricercatore – Luca Tonin – e due dottorandi, Gloria Beraldo e Stefano Tortora).

“Il cervello di ogni persona – spiega – si attiva in maniera un po’ diversa. Pertanto, il software deve essere ‘cucito’ su misura del piccolo paziente”. Ma l’ambizione è un’altra: “In collaborazione con la professoressa Agnese Suppjei dell’Università di Ferrara, stiamo cercando di raccogliere una grande quantità di dati che ci permetta di creare un programma di intelligenza artificiale basato sul deep learning che funzioni direttamente per tutti i soggetti”. In altre parole, un software così evoluto, che sia indipendente dalle caratteristiche del soggetto. La sfida è appena iniziata. Lo studio, che è autofinanziato dall’Università Patavina, forte dei suoi 800 anni di storia accademica, e presentato nel corso dell’ultima edizione del DigitalMeet 2019, festival nazionale dedicato all’alfabetizzazione digitale (www.digitalmeet.it), è in grado di creare un software personalizzato, costruito su misura, che deve essere ‘testato’ durante una fase di addestramento. Non solo, secondo la prospettiva del mutual learning, in questo caso, “sia l’operatore umano sia il software si adeguano per lavorare in perfetta sinergia”: il programma, infatti, durante l’interazione con l’utente, modifica in automatico i suoi parametri per interpretare correttamente i comandi dell’utente.

Allo stesso modo l’utente impara come controllare al meglio il software, in un processo sinergico che porta ad una specie di simbiosi tra il sistema umano e quello artificiale. Siamo solo all’inizio. L’obiettivo di un software generale, valido per tutti è raggiungibile, assicura Menegatti. “Lo è ma è necessario analizzare una grande mole di dati e tutto ciò, soprattutto in ambito pediatrico, non è proprio semplice”. La collaborazione con l’ospedale di Cona dell’Università di Ferrara mira proprio a coinvolgere almeno 100 bambini. L’ambizione dei ricercatori è che l’innovazione tecnologica possa essere applicata, quando sarà perfezionata, nella vita quotidiana, al di fuori del laboratorio. Le tecniche di BCI (Brain Computer Interface), infatti, sono pensate per quelle persone che non sono in grado di comunicare, come i pazienti che si sono svegliati dal coma o coloro che sono stati colpiti da un ictus. Per quanto riguarda l’ambito pediatrico, l’applicazione della BCI diventa interessante per i bambini che sono in coma a causa ad esempio di un annegamento o che hanno subito un trauma cranico. “La scienza medica – spiega Menegatti – non ha ancora delle certezze in materia. Sembra che ci siano dei momenti in cui i piccoli pazienti sono coscienti ma non si possono muovere”.

Ecco perché lo strumento della BCI – che esiste già da 30 anni, per la prima volta applicato ai bambini- diventa fondamentale, per “tradurre” appunto i segnali elettrici del cervello in comandi per un computer o un robot. “La ricerca in questione – sottolinea Gianni Potti, founder di DigitalMeet 2019 – ci dimostra che il robot che assiste l’uomo può svolgere un ruolo molto importante. Tuttavia, io credo che mai e poi mai la tecnologia potrà sostituire l’uomo. Noi abbiamo un’anima, le macchine, seppure intelligenti, no”. “Oggi la sfida della cultura digitale diventa motivo di sviluppo per l’Italia. Lo è a maggior ragione nel campo della medicina e della salute in chiave 4.0”, aggiunge Potti. Proprio per questo motivo, diventa interessante l’applicazione della BCI in ambito medico. Un robot, infatti, può aiutare un paziente colpito da un ictus, durante la fase di riabilitazione. “Se è vero che quando si riscontra un ictus, una zona del cervello, quella danneggiata appunto, è ‘persa’, è altrettanto vero – spiega Menegatti – che, secondo la letteratura scientifica, le zone vicine a quella colpita – le zone cosiddette perilesionali – possono essere ‘allenate’ ed essere in grado di reimparare certe funzioni come, ad esempio, l’uso della mano.

“Noi, oggi, siamo in grado di capire attraverso la BCI se la ‘zona’ del cervello attivata dal paziente è quella giusta oppure no”, spiega Menegatti. “Durante gli esercizi di riabilitazione, dunque, un robot può aiutare il paziente attivandosi solo quando quest’ultimo usa la zona ‘giusta’ del cervello. In caso contrario, il robot rimane fermo e non lo aiuta”. Gli studi devono andare avanti. Servono risorse. La campagna di fundraising dell’ateneo di Padova è appena cominciata. La prossima sfida è a maggio 2020 quando si svolgerà il Cybathlon, la paraolimpiade della neurorobotica, un campionato internazionale in cui atleti con disabilità motorie si sfidano coadiuvati da tecnologie assistive. Tanti paratleti, tanti avatar e una gara. La squadra dell’Università di Padova si sta già allenando e cerca finanziamenti per ottenere la medaglia d’oro (come quella conquistata dallo Ias-Lab di Padova nel 2019), ma soprattutto per far vincere la ricerca.