‘Momento Sputnik’ dell’AI, in riferimento alla ‘sveglia’ data a suo tempo dalla Russia agli Usa nella corsa spaziale. Ma anche Temu dell’intelligenza artificiale generativa e simil-iPhone da 30 dollari. Le metafore per DeepSeek già si sprecano, insieme a lodi, accuse e critiche. Il lancio dell’ultimo modello R1 dell’app cinese di intelligenza artificiale “dovrebbe essere una sveglia per le nostre industrie, che dovrebbero essere concentrare al massimo sulla competizione per vincere”, ha commentato il Presidente Usa Donald Trump dopo il terremoto in Borsa provocato dalla startup dal ‘budget ridicolo’ ma sostenuta da un hedge fund miliardario.

DeepSeek non è spuntata fuori dal nulla. Per capire come abbia sconvolto i mercati, bisogna guardare alla sua storia e alle intuizioni del suo fondatore, ma anche ai suoi ultimi annunci: un mix di numeri e risultati tecnologici che hanno creato la tempesta perfetta sui mercati.

DeepSeek, cosa è successo

La startup è nata nel 2023 dal laboratorio AI dell’hedge fund HighFlyer (già nel 2019 aveva 1,4 mld di dollari di asset, secondo il South China Morning Post) ed è stata creata dal quarantenne Lian Wengfeng.

DeepSeek ha lanciato un assistente AI open-source utilizzando chip molto meno costosi e una quantità inferiore di dati rispetto ai concorrenti americani come ChatGPT, e ha rapidamente scalato le classifiche delle app più scaricate e messo in dubbio tutte le convinzioni degli investitori: per sviluppare i modelli di intelligenza artificiale servono davvero centinaia di milioni? Serve spendere 500 miliardi per un gigantesco ‘Stargate’ targato OpenAI, Oracle e Softbank, per le infrastrutture digitali, o per le nuove centrali nucleari che le alimenteranno?

Insomma, la corsa all’intelligenza artificiale ora vede in testa una piccola azienda che, nonostante le sanzioni statunitensi che limitano l’accesso della Cina ai semiconduttori avanzati, è riuscita a creare il suo modello con una frazione dei costi, mettendo in discussione la supremazia tecnologica USA con una filosofia open source, aperta alla comunità e gratuita, e un modello (R1,appunto) che secondo la startup è al pari dello o1 di OpenAI, progettato per il ragionamento e la matematica. Ed effettivamente gli esperti ne sono rimasti impressionati.

Secondo Roberto Navigli, papà di Minerva, la famiglia di large language model che lo scorso anno ha aperto le danze della Gen AI italiana, “era scontato che si arrivasse a questo punto. Non si può andare avanti solo con una ‘potenza di fuoco’ esagerata come quella americana, e tutto questo conferma che la direzione di voler rendere sostenibili i modelli è quella giusta. In qualche modo è un assist ai modelli aperti come Minerva, con tutti i limiti del caso. Una direzione di apertura che manca molto da tempo negli Usa. Così si scardina quel meccanismo secondo cui le big tech devono dettare legge su cosa viene reso noto e cosa no”.

🚀 DeepSeek-R1 is here!

⚡ Performance on par with OpenAI-o1

📖 Fully open-source model & technical report

🏆 MIT licensed: Distill & commercialize freely!🌐 Website & API are live now! Try DeepThink at https://t.co/v1TFy7LHNy today!

🐋 1/n pic.twitter.com/7BlpWAPu6y

— DeepSeek (@deepseek_ai) January 20, 2025

Le reazioni delle Big Tech

Da Satya Nadella di Microsoft a Sam Altman di OpenAI, i big dei giganti americani si sono affrettati ad accogliere con un sorriso la competizione – mentre nel dietro le quinte mettono insieme team di ingegneri per capire come diavolo abbia fatto DeepSeek a eguagliare i risultati dei modelli di intelligenza artificiale Made in Usa, che costano centinaia di miliardi di dollari.

Tutto questo potrebbe essere “positivo” per i giganti americani del tech, ha detto Trump: “Invece di spendere miliardi e miliardi, si spende di meno e si arriverà, sperabilmente, alla stessa soluzione”.

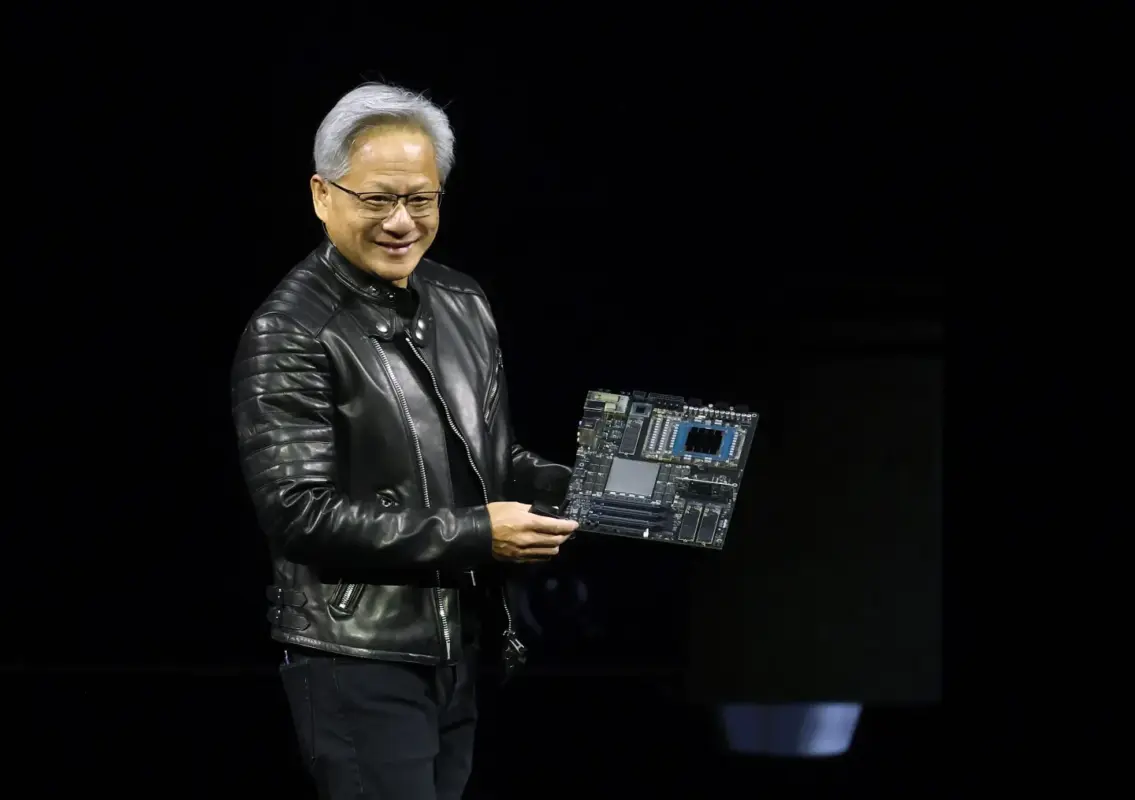

Il crollo di Nvidia

Per ora però restano i numeri negativi da record registrati dal mercato, con Nvidia, l’azienda che alimenta la corsa AI, che è crollata del 17,5% bruciando 600 mld di dollari in un giorno. Con l’app cinese che ha superato i download di ChatGpt sull’Apple store, anche Nvidia è stata costretta ad ammettere che “DeepSeek è un eccellente progresso dell’intelligenza artificiale” e che “il lavoro di DeepSeek mostri come nuovi modelli possono essere creati”, sfruttando “modelli ampiamente disponibili e un calcolo completamente conforme al controllo delle esportazioni”.

I tre annunci da tenere a mente

Sui motivi che hanno spinto i mercati al panico va fatta un po’ di chiarezza.

DeepSeek rilascia i suoi modelli da tempo, ma sono le ultime tre release ad aver creato la tempesta perfetta, tra fondi impiegati e risultati tecnologici:

- La cifra di 5,6 mln di dollari che ha sconvolto la Silicon Valley fa riferimento alla potenza di calcolo utilizzata per l’addestramento dell’intelligenza artificiale ed è un numero pubblicato già a dicembre. In quel caso si parlava dell’addestramento di V3, large language model dell’azienda su cui è basato il nuovo R1. Già in quel caso erano stati dichiarati livelli di performance simili a quelli dei grandi modelli americani.

- Pochi giorni fa è arrivato R1, che ha impressionato per le capacità di ‘ragionamento’ sui problemi matematici più complessi, come fa l’o1 di OpenAI.

- Lunedì è stato annunciato un altro modello, ma per la generazione di immagini: si chiama Janus Pro, e anche in questo caso la startup parla di un prodotto più avanzato di competitor come Dall-E.

I dubbi su DeepSeek

La startup con sede nella città cinese di Hangzhou è riuscita a sconvolgere il tech proprio perché ha raggiunto risultati simili a OpenAI senza utilizzare gli stessi processori Nvidia più avanzati, gli H100 (il prezzo è arrivato anche a 40mila dollari l’uno) la cui diffusione in Cina è stata bloccata dagli Usa. Ha usato invece gli H800, sempre di Nvidia, ma molto più economici.

Quante Gpu sono state usate? DeepSeek dice di averne utilizzate 2.000 (rispetto alle 16.000 necessarie per ChatGpt) ma su questo le stime oscillano.

Secondo alcuni le Gpu della startup vanno dalle 10mila alle 50mila. Ma su quest’ultimo numero, riportato in particolare dal Ceo di un’altra azienda, Alexander Wang di Scale AI, per ora non sembrano esserci fonti certe.

“Tra i dubbi sui modelli DeepSeek ci sono sicuramente quelli relativi ai bias, che vanno chiariti: l’allineamento del modello al pensiero del Governo cinese va oltre le tradizionali iniziative sulla sicurezza dei modelli stessi”, spiega Navigli.

Roberto Navigli, il professore che lavora alla Gen AI italiana

Il budget di DeepSeek

Altro dubbio sollevato su quanto dichiarato finora da DeepSeek: posto che si parla di cifre molto inferiori a quelle americane (nell’ordine delle centinaia di milioni, per ChatGpt), è davvero di pochi milioni il budget utilizzato per sviluppare i modelli? Philipp Schimd, ingegnere specializzato in Llm (large language model) di Hugging Face (la principale piattaforma dove condividere gli Llm) ha ricordato che il costo da 5,6 mln di dollari riportato in queste ore riguarda solo il modello base di DeepSeek, escludendo il training dell’ultima versione rilasciata, R1.

La censura

Tra le altre critiche, ci sono quelle relative alla censura cinese. Già circolano video dell’app che non riesce a rispondere a domande su Winnie the Pooh, da anni alter ego poco lusinghiero di Xi Jinping mai gradito – e oscurato su Internet – dal Governo cinese.

Se si chiede a R1 di parlare del significato storico di piazza Tienanmen il modello inizia a digitare informazioni sul massacro, ma elimina subito la risposta e la sostituisce con un: “Mi dispiace, è oltre il mio ambito. Parliamo di qualcos’altro”. Sembra che la censura faccia il suo dovere solo sulla versione principale di R1. Secondo una prova di Fortune.com, le risposte non vengono censurate nelle versioni più piccole del modello, diffuse da DeepSeek attraverso altri modelli open source come Llama e Qwen.

Non mancano le accuse di plagio. Josh Kushner di Thrive Capital, uno dei maggiori investitori statunitensi, ha definito DeepSeek “un modello cinese che è stato addestrato sui principali modelli statunitensi”. Ma se c’è qualcuno che trema in questo momento sono proprio i fondi di venture capital, esposti per miliardi nella corsa all’intelligenza artificiale.

Sulle accuse di aver copiato i modelli americani, Navigli ricorda che “tanti modelli usano dati senza permesso. In più qui si parla di ricerca scientifica, e la scienza si costruisce mattone dopo mattone, anche grazie al lavoro degli altri. È normale che il modello sia stato costruito anche a partire dalla ricerca fatta in occidente”.

Come ha fatto DeepSeek

“L’articolo scientifico che ha accompagnato il rilascio di R1 non è ricchissimo, ma ha un approccio interessante e nuovo, per certi versi”, spiega Navigli. “Per tutta la parte a valle del modello fondazionale base non si usano dati annotati (dataset che includono informazioni strutturate e arricchite con etichette o metadati, utilizzati per migliorare il processo di addestramento) e questo è interessante”.

Ma è l’approccio open source (simile alla filosofia seguita dal modello italiano Minerva su cui lavora Navigli insieme al suo team della Sapienza) la cosa veramente dirompente: “Così posso visionare il ragionamento fatto dal modello, vedere cosa succede ‘sotto il cofano’, mentre in o1 non sappiamo come si è arrivati a un dato risultato”.

È stato spiegato che a premiare DeepSeek sia stata la filosofia utilizzata per l’architettura software, facendo a meno dell’hardware più avanzato. Le architetture software utilizzate sono la Multi-head Latent Attention (MLA) e la Mixture-of-Experts (MoE), che comporta l’addestramento di specifiche parti del modello per affrontare problemi altrettanto specifici. Il MoE è un approccio che esiste da decine di anni, e anche l’applicazione agli Llm non è una novità, spiega Navigli. “In questo caso però è stato usato con una certa attenzione al risparmio e alla qualità dei dati, e questo dà un impatto enorme”.

Garbage in, garbage out

Il concetto è quello del garbage in, garbage out: i risultati di un modello dipendono da quali dati vengono usati per addestrarlo. DeepSeek ha usato “15 trilioni di token, più o meno la quantità che usa Llama. Ma il punto è cosa c’è lì dentro: quanti dati ci sono in ciascuna lingua, quanti sono stati creati ad hoc per ragionare. Per ora tutto questo non si sa”.

Sull’approccio votato all’efficienza dei cinesi sono arrivate altre critiche dagli analisti Usa. Sono convinti che non è con il metodo cinese (che definiscono un ‘reverse engineering’ sui modelli precedenti) che si potrà ottenere l’Agi, l’artificial general intelligence a cui puntano i grandi investimenti americani.

Il campanello d’allarme per l’Europa

L’arrivo di R1 è un campanello d’allarme per l’Europa? Secondo Navigli “assolutamente sì: l’Europa è in un sonno profondo. È un problema di approccio: non basta finanziare qualche progetto europeo in più, bisogna disseminare innovazione. In Italia le aziende faticano ad essere veramente innovative, manca una vera cultura della ricerca, e bisogna puntare sulle competenze, sui dottorati. Perché non tutti i piccoli ce la possono fare: solo Davide può vincere contro Golia.

L’intuito di Liang Wenfeng

La Cina il suo Davide lo ha trovato, ma alla base del successo di DeepSeek c’è anche l’intuito del suo creatore.

Da anni Liang Wenfeng utilizzava l’AI per il trading del suo hedge fund, e proprio grazie ai fondi di HighFlyer si è assicurato migliaia di chip Nvidia prima del blocco delle esportazioni Usa in Cina del 2022. Questo è stato un vantaggio già in Cina, dove con gli altri attori tecnologici la contesa per l’AI è molto agguerrita. Già quasi 8 anni fa il fondo utilizzava l’Ai per le decisioni di investimento, ma quella che per il fondatore era un’opportunità di business si è trasformata in una visione: fornire l’AI a tutti in maniera trasparente, senza aspettare le innovazioni Usa: “La maggior parte delle aziende cinesi copia e adatta, noi vogliamo creare”, ha detto Wenfeng. Una missione che alle aziende Usa è costata centinaia di miliardi. Per ora.