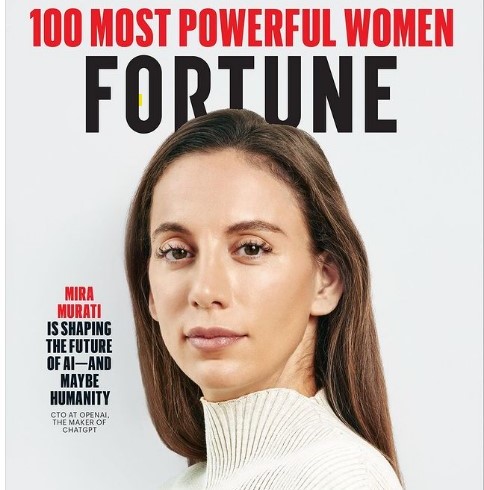

Qualche minuto prima che Mira Murati, Cto di OpenAI, ci riceva in una sala conferenze nella sede centrale dell’azienda a San Francisco, un altro dirigente lascia la stanza: è il cofondatore e Ceo Sam Altman. Il nerd simbolo della rivoluzione dell’AI entra come un lampo, raccoglie le sue cose – che consistono solo in un laptop – e si allontana silenziosamente, così che Murati possa prendere il centro della scena.

È Altman generalmente il volto pubblico dell’azienda più nota nel campo dell’AI; tra l’altro, era tornato da poco da Washington, da un confronto con il Congresso sulla regolamentazione. Meno nota, ma altrettanto cruciale per l’ascesa repentina di OpenAI, la Cto spesso opera appena fuori dai riflettori. Murati, 34 anni, è la dirigente che gestisce il popolare chatbot ChatGpt e DALL-E, un sistema di intelligenza artificiale che crea immagini dal testo. Sono i prodotti che hanno spinto in alto OpenAI, partito otto anni fa come laboratorio di ricerca senza scopo di lucro.

Dopo il lancio, nel novembre 2022, ChatGpt ha raccolto in soli due mesi oltre 100 milioni di utenti mensili attivi, diventando l’applicazione di consumo cresciuta più velocemente nella storia. E anche se questi prodotti continuano a evolversi, capita di dover dare conto di problemi tecnici imbarazzanti o addirittura allarmanti, ed è Murati che sempre più spesso affronta un pubblico estremamente attento a ogni cambiamento o passo falso.

Anche se si stima che la crescita di ChatGpt tra i consumatori negli ultimi mesi sia rallentata, l’utilizzo tra i clienti aziendali è in piena espansione. Quest’anno, OpenAI è sulla buona strada per registrare un mld di dollari di entrate. Sarebbe un bel salto: i documenti finanziari trapelati a inizio anno, relativi a un round di investimento, indicano che nel 2022 OpenAI ha riportato poco meno di 30 mln di dollari di entrate. E l’accordo della società con il gigante del software Microsoft, che Murati ha contribuito a supervisionare, ha portato moltissime nuove possibilità di distribuzione, per non parlare di un investimento di 10 mld di dollari.

Proprio come il semplice aspetto esterno dell’ufficio di OpenAI contraddice l’arredamento raffinato dell’interno, Murati si presenta molto casual, in jeans e maglietta, ma parlando con lei si percepisce subito una forte energia interiore. Risponde alle domande lentamente e ponderatamente, con un tono allo stesso tempo rilassato e appassionato. Dopotutto, Murati dice che passa il suo tempo a pensare non solo alle ultime funzionalità di ChatGpt, ma anche a chiedersi se l’AI porterà alla fine dell’umanità.

Murati è entrata in OpenAI nel 2018, dopo un periodo in Tesla. Ma la sua non è la tradizionale carriera da Silicon Valley. Ha trascorso l’adolescenza nella nativa Albania, crescendo durante il passaggio del Paese balcanico da un sistema totalitario comunista a un governo più democratico. La transizione è stata improvvisa e in qualche modo caotica, ma ha detto che riconosce al vecchio regime una cosa: c’era un’intensa competizione per la conoscenza. E anche se Internet in Albania era piuttosto lento allora, lei già cercava risposte alle sue molte domande (incluso come funziona il cervello umano) e modi per applicare la tecnologia ai più grandi problemi della vita. All’età di 16 anni, Murati ha ottenuto una borsa di studio per frequentare una scuola internazionale a Vancouver, in Canada, e ha lasciato il suo Paese d’origine; in seguito, ha conseguito una laurea in Ingegneria a Dartmouth e alla fine è andata a San Francisco per una posizione da senior product manager per la Model X di Tesla.

Una delle cose che l’ha attratta inizialmente verso OpenAI è stata la convinzione dell’azienda di poter realizzare l’AGI (artificial general intelligence); un computer in grado di capire, imparare e pensare proprio come può fare un essere umano. Anche lei crede nell’AGI. Ma ciò non significa che non abbia le idee chiare su alcuni dei rischi molto reali che l’AI pone. Abbiamo chiacchierato con Murati per capire meglio le sfide di OpenAI, le ultime versioni di DALL-E e le nuove caratteristiche di ChatGpt, che includeranno comandi vocali. Questo potrebbe rendere l’AI ancora più user-friendly, e aumentarne la diffusione.

Quali sono le migliori applicazioni di DALL-E, in particolare della nuova versione, DALL-E 3, che si integra con ChatGpt?

Lo stiamo provando, quindi dobbiamo ancora vedere come le persone lo useranno. E inizialmente ci siamo concentrati su tutte le cose che possono andare storte. Penso che ci siano usi creativi. Si può creare qualcosa di veramente personalizzato. Se tuo figlio fosse molto appassionato di rane e tu volessi inventare una storia su questo, in tempo reale lui potrebbe dare un contributo alla storia. C’è molta creatività e co-creazione. E poi penso che, sul posto di lavoro, creare nuove idee possa essere molto più facile. Rende il ciclo iniziale di iterazioni molto più veloce.

Può spiegarci i punti più salienti?

Dunque, in generale, e questo è ciò di cui parliamo da due anni, il nostro obiettivo è arrivare all’AGI, e vogliamo arrivarci in un modo che faccia del bene all’umanità. Per fare questo, è necessario che questi modelli abbiano un concetto solido del mondo. Quindi quello che stiamo facendo è riunire tutte queste modalità in ChatGpt. Stiamo portando DALL-E 3 su ChatGpt, e prevedo che sarà un grossissimo rompicapo ma anche una cosa meravigliosa con cui interagire. Un’altra modalità è la voce. Ci sarà la possibilità di parlare con ChatGpt in tempo reale. Non ho intenzione di fare una demo. Ma, semplicemente, ci si può parlare

… [Mira Murati afferra il suo telefono e apre ChatGpt, quindi chiede all’app di dirle “qualcosa di interessante” tramite un comando vocale. Il chatbot risponde: “Sapevi che il miele non va mai a male?”].

In pratica sta facendo una demo.

È molto più facile da mostrare che da descrivere. Fondamentalmente questo sta dando alle persone la possibilità di interagire con la tecnologia in modo molto naturale.

Facciamo un passo indietro: c’è molto interesse per il prodotto, ma anche per le persone che sono dietro a tutto questo. Quali sono state le esperienze che l’hanno formata?

Certamente crescere in Albania. Ma anche i miei inizi nel settore aerospaziale e l’esperienza a Tesla sono stati momenti molto formativi, avendo sperimentato il percorso completo di progettazione e distribuzione di un intero veicolo. E sicuramente essere venuta a OpenAI. Quando sono arrivata eravamo in 40 o 50 ed eravamo essenzialmente un laboratorio di ricerca, ora siamo un’azienda in piena regola con milioni di utenti. [OpenAI ora ha circa 500 dipendenti].

Come ha conosciuto Sam Altman e come è arrivata a OpenAI?

In Tesla lavoravo alle applicazioni di AI. Ma ero più interessata all’intelligenza artificiale generale. Non ero sicura che ci si potesse arrivare in quel momento, ma sapevo che, se anche ci fossimo andati molto vicino, le cose che avremmo costruito lungo la strada sarebbero state incredibili, pensavo che sarebbe stato sicuramente il più importante set di tecnologie che l’umanità abbia mai costruito. Quindi, volevo farne parte. OpenAI era una specie di gioco, perché all’epoca erano solo OpenAI e DeepMind [di Google] a lavorarci. E la mission di OpenAI mi ha davvero entusiasmato, costruire una tecnologia a beneficio delle persone. Io sono entrata quando era un’organizzazione no-profit. Ovviamente da allora abbiamo dovuto evolverci: questi supercomputer sono molto costosi. [Nel 2019 OpenAI è diventata una società for-profit, nonostante sia ancora governata da un consiglio di amministrazione no-profit]. In quel periodo, ricordo di aver incontrato Greg Brockman e Ilya Sutskever e Wojciech Zaremba e poi Sam Altman. E mi è diventato molto chiaro che quello era il gruppo di persone con cui volevo lavorare.

Ci riporti al momento in cui avete rilasciato ChatGpt per la prima volta nel mondo. Aveva la sensazione che sarebbe stata una cosa così grande?

No. Pensavamo che sarebbe stato importante e ci eravamo preparati per questo. Ma poi, naturalmente, poche ore dopo, tutti i preparativi sono diventati completamente inadeguati. Abbiamo dovuto adeguarci e cambiare il modo di operare. Ma penso che questa sia in realtà la chiave di tutto ciò che stiamo facendo, perché il ritmo del progresso tecnologico è incredibilmente rapido. Abbiamo dovuto farlo con ChatGpt. Lo avevamo usato solo internamente. E noi stessi non ne eravamo rimasti così impressionati, perché avevamo già usato Gpt-4. E quindi non pensavamo che ci sarebbe stato un tale scompiglio.

Un’altra cosa che ha comportato il rilascio di ChatGpt è stata una sorta di “corsa agli armamenti”. C’è Google, ovviamente, ma anche un sacco di altri competitor. Quali sono i risvolti negativi?

Penso che il rovescio della medaglia sia una corsa al ribasso sulla sicurezza. Questo è un risvolto negativo, di sicuro.

Un risvolto molto negativo.

Sì. Ognuno di noi deve impegnarsi a non farlo e resistere alle pressioni. Penso che OpenAI abbia le giuste motivazioni per non farlo. Ma penso anche che la competizione sia positiva perché può spingere l’avanzamento e il progresso. Rende più probabile che le persone ottengano i prodotti che amano. Non credo che la concorrenza sia un male di per sé. Lo è se tutti sono motivati principalmente solo da questo, perdendo di vista i rischi e ciò che è in gioco, sarebbe un problema enorme.

Lei è sicura che, se la concorrenza continua ad accelerare – mentre i vostri investitori si aspettano un rendimento – quelle motivazioni possano resistere a tutte queste pressioni?

Sono fiduciosa sulla forza delle nostre motivazioni e sul progetto che abbiamo. Anche con i nostri partner, per il modo in cui abbiamo strutturato le cose, siamo molto allineati. Ora, credo che la parte più difficile sia prevedere le potenzialità emergenti e anticipare alcuni dei rischi di implementazione. Perché, in fin dei conti, è necessario istituzionalizzare e rendere operative queste cose.

Come fa a essere sicura di riuscire a considerare le possibili conseguenze di ogni nuova iterazione? Come affrontate la situazione quando vi trovate in scenari difficili?

Si parte dal team. Prima ancora di avere un prototipo, consideriamo attentamente i dati che stiamo usando e ci assicuriamo di sentirci a posto sui diversi aspetti. È un ciclo molto iterativo, impariamo cose lungo la strada. Una volta che abbiamo un prototipo, la prima cosa che facciamo è testarlo internamente e coinvolgere i red-teamer [gli esperti il cui compito è individuare eventuali vulnerabilità, ndr] in aree specifiche di cui siamo preoccupati. Ad esempio, se vediamo che il prototipo è incredibilmente bravo a creare volti fotorealistici, diciamo, allora allerteremo i red-teamer su questo punto e cercheremo di capire quanto sono negative le cose che possono essere fatte con questo modello. Poi, sulla base di questi risultati, torniamo indietro e implementiamo delle contromisure. Ogni volta controlliamo l’aspetto dell’output, perché bisogna assicurarsi che ci sia una sorta di equilibrio, che non si sia reso il prodotto completamente inutile o frustrante. È un equilibrio difficile, che lo rende utile, meraviglioso e sicuro. E così in questo momento, con DALL-E 3, se c’è qualcosa nella richiesta di creazione di volti che riguarda caratteristiche sensibili, il modello semplicemente rifiuterà la richiesta. Ma non vogliamo che vengano rifiutate richieste in cui l’utente domanda al modello di fare qualcosa che non è negativo. Ecco, questo è il tipo di sfumatura che ci troviamo ad affrontare, ma da qualche parte bisogna cominciare, e in questo momento siamo più conservatori e meno permissivi perché la tecnologia è nuova. Poi, man mano che comprendiamo meglio ciò che il modello sta facendo e riceviamo più input dai red-teamer, possiamo usare quei dati per rendere le nostre policy o use case più sfumati ed essere più permissivi nei confronti di ciò che fa la tecnologia. È stato questo l’indirizzo che abbiamo seguito.

So che ci sono diverse criticità relative al copyright al momento. (Negli ultimi mesi, diversi scrittori e creativi hanno citato in giudizio OpenAI, accusando la società di addestrare i suoi modelli usando la loro scrittura senza consenso o compenso, ndr). Pensa che queste rappresentino una minaccia a lungo termine per l’addestramento dei modelli?

Stiamo lavorando molto con editori e creatori di contenuti. In fin dei conti, penso che le persone vogliano che questa tecnologia faccia progressi, sia utile e migliori loro la vita. Stiamo cercando di capire cosa potrebbe funzionare, siamo in prima linea. Dobbiamo prendere alcune decisioni molto difficili e dobbiamo solo lavorare con le persone per stabilire cosa fare. Questa è una tecnologia diversa, quindi perché stiamo usando le stesse policy e lo stesso approccio di prima? Ci stiamo lavorando ma non abbiamo una soluzione. Stiamo lavorando con editori e creatori di contenuti. È sicuramente molto complesso, e molto dovrà cambiare. Quello che stiamo facendo oggi è probabilmente solo l’inizio della comprensione dell’economia della condivisione e dell’attribuzione dei dati. Quando il valore aggiunto di un modello risiede nelle persone che lo usano, come si può anche solo misurarlo?

Dal punto di vista normativo, ha detto di essere favorevole alla regolamentazione. Quali sono i punti più importanti? E cosa la preoccupa di più dell’AI?

Penso che la cosa più importante che le persone possano fare in questo momento sia comprendere l’AI. Ma guardando al futuro, vogliamo che queste tecnologie siano profondamente integrate nel nostro sistema. Se queste tecnologie saranno nella nostra infrastruttura elettrica, ci sarà bisogno non solo degli aspetti tecnici, ma anche del quadro normativo. Dobbiamo iniziare da qualche parte affinché alla fine diventi una realtà. Un altro punto molto importante è pensare ai modelli che avranno quelle che chiamiamo potenzialità pericolose. Ci sono due tipi di uso improprio: c’è un uso improprio ‘normale’ e c’è una svolta insidiosa di questi sistemi di intelligenza artificiale. E nel caso in cui si verifichi questa svolta insidiosa, cosa dovremmo fare? Perché non si tratta solo di uso quotidiano. È una tecnologia che potrebbe influenzare la politica internazionale più di qualsiasi altra cosa che abbiamo mai costruito. La questione più vicina è quella delle armi nucleari, naturalmente. Quindi si tratta di capire come possiamo costruire una regolamentazione che mitighi questi rischi.

Abbiamo visto emergere due ipotesi sul futuro dell’AI: una molto utopica e una che la vede come una minaccia esistenziale. Qual è la sua speranza per il futuro?

Penso che siano entrambe possibilità realistiche. Sono molto ottimista. Ma la tecnologia stessa porta intrinsecamente con sé entrambe le possibilità, e non è diversa da altri strumenti che abbiamo costruito nella misura in cui se ne può fare un uso improprio e c’è la possibilità di fare cose davvero orribili, persino eventi catastrofici. La cosa unica, in questo caso, è il fatto che c’è anche la minaccia esistenziale della fine della civiltà. Penso che ci sia [solo] una piccola possibilità che ciò accada, ma c’è, e quindi vale davvero la pena pensarci. Abbiamo un intero team dedicato a questo, e una enorme potenza di calcolo. Chiamiamo questo progetto Super Alignment e si tratta di come allineare questi sistemi e assicurarci che agiscano sempre in conformità con i nostri valori. E questo è difficile.

La versione originale di questo articolo è disponibile su Fortune e su Fortune.com